La electrónica siempre ha sido un caldo de cultivo para los ciclos virtuales. En la década de 1980, las unidades de disco de alta capacidad permitieron a las empresas de software como Microsoft crear aplicaciones más potentes que requerían más almacenamiento.

La electrónica siempre ha sido un caldo de cultivo para los ciclos virtuales. En la década de 1980, las unidades de disco de alta capacidad permitieron a las empresas de software como Microsoft crear aplicaciones más potentes que requerían más almacenamiento. Esto permite aplicaciones aún más poderosas que requieren más almacenamiento. A medida que Intel metió más y más procesamiento en sus microprocesadores, las aplicaciones computacionalmente intensivas como gráficos y video parecían llenar el margen de procesamiento. Y, por supuesto, está Internet, que hace que cada ciclo virtual parezca diminuto.

Por lo tanto, no debería sorprender que los centros de datos (y, más recientemente, la computación en la nube) se estén beneficiando de la tecnología de hardware en todos los niveles dentro del centro de datos, impulsando la innovación. Con la llegada de la computación en la nube, el procesamiento más rápido, la recuperación de datos más rápida, la mayor capacidad de almacenamiento y la comunicación más rápida entre máquinas son más importantes que nunca.

tecnología de centro de datos

Con un tamaño de mercado global de $52.8 mil millones en 2012, según la firma de investigación Gartner, hay mucho espacio para la innovación de hardware en la porción de servidores del mercado de centros de datos. Llevamos más de dos meses sin presentar una nueva familia de servidores más potente porque ajustar el rendimiento del hardware puede darnos una ventaja significativa en el mercado. Cada nuevo centro de datos suele tener más de 100 000 servidores implementados, por lo que la ventaja de estar a la cabeza es significativa. En menor medida, las nuevas tecnologías de almacenamiento y comunicación también contribuyen al ciclo virtual.

Los servidores pueden ser la tecnología central del centro de datos, pero las tecnologías aparentemente mundanas, como el consumo de energía, las comunicaciones y el aire acondicionado, contribuyen al tamaño general del mercado en términos de dólares. Un solo centro de datos puede utilizar hasta 10,5 millones de vatios de potencia. En conjunto, los centros de datos representan el 2,2% del consumo total de electricidad de EE. UU. Se prevé que este porcentaje aumente a medida que las personas y las empresas consuman más datos, especialmente más videos. Una hoja informativa del Programa Nacional de Información sobre Eficiencia Energética del Centro de Datos establece que la cantidad de energía consumida por los centros de datos continuará creciendo a una tasa del 12 % por año.

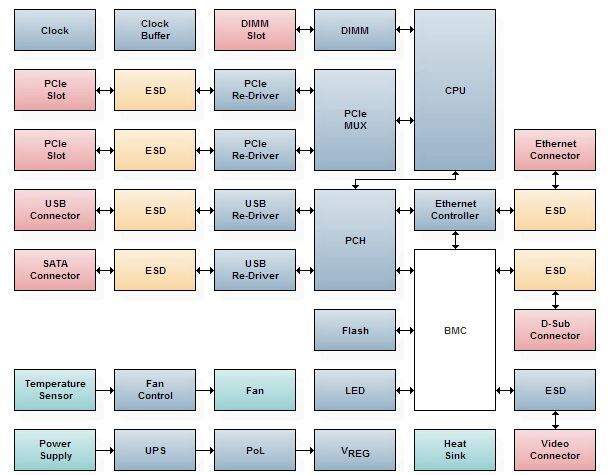

La necesidad constante de velocidad, almacenamiento de alta densidad y un enfoque en la eficiencia energética hacen que el diseño de la placa base del servidor sea uno de los más desafiantes en los equipos electrónicos de la actualidad. La figura 1 muestra un diagrama de bloques de los componentes principales de una placa base de servidor típica.

Los microprocesadores son fundamentales para el diseño del servidor y, por lo general, representan la mayor parte del costo y el consumo de energía de la placa base. Hacer más con menos es la respuesta obvia. El desafío del diseño sigue siendo cómo implementar multiprocesamiento y subprocesos múltiples más eficientes. Recientemente, para los chips, el término más eficiente significa no solo más MIP por chip, sino también más MIP por vatio. La técnica más común para implementar el multiprocesamiento es diseñar chips con múltiples núcleos de procesamiento integrados. Esto habilita el subprocesamiento múltiple del software, lo que permite que el servidor ejecute múltiples flujos de código simultáneamente. Sin ella, la computación en la nube probablemente no sería posible. Multithreading también reduce el consumo de energía. Además de las mejoras multi-core/multi-threading, el procesador ahora puede ejecutar instrucciones de 124 bits para un rendimiento significativamente mejorado.

A medida que la computación en la nube se vuelve más frecuente, el centro de datos tradicional, que colocaba todos los componentes principales en el mismo espacio físico, está evolucionando hacia la próxima generación, donde la redundancia y la comunicación de alta velocidad son más importantes que nunca. La fotónica de silicio es la premisa para la transferencia de datos a la velocidad de la luz entre subsistemas futuros, pero los ingenieros de diseño de hoy deben optimizar todos los aspectos de la tecnología de servidor, almacenamiento, comunicaciones y computación.

Los avances continúan en los procesadores multinúcleo que implementan arquitecturas informáticas multihilo. Encontrar soluciones para los problemas de integridad de las señales es un desafío continuo con tecnologías como los recontroladores. La computación en la nube, por otro lado, ha revolucionado la tecnología de almacenamiento, tanto en términos de capacidad como de arquitectura.